Blog

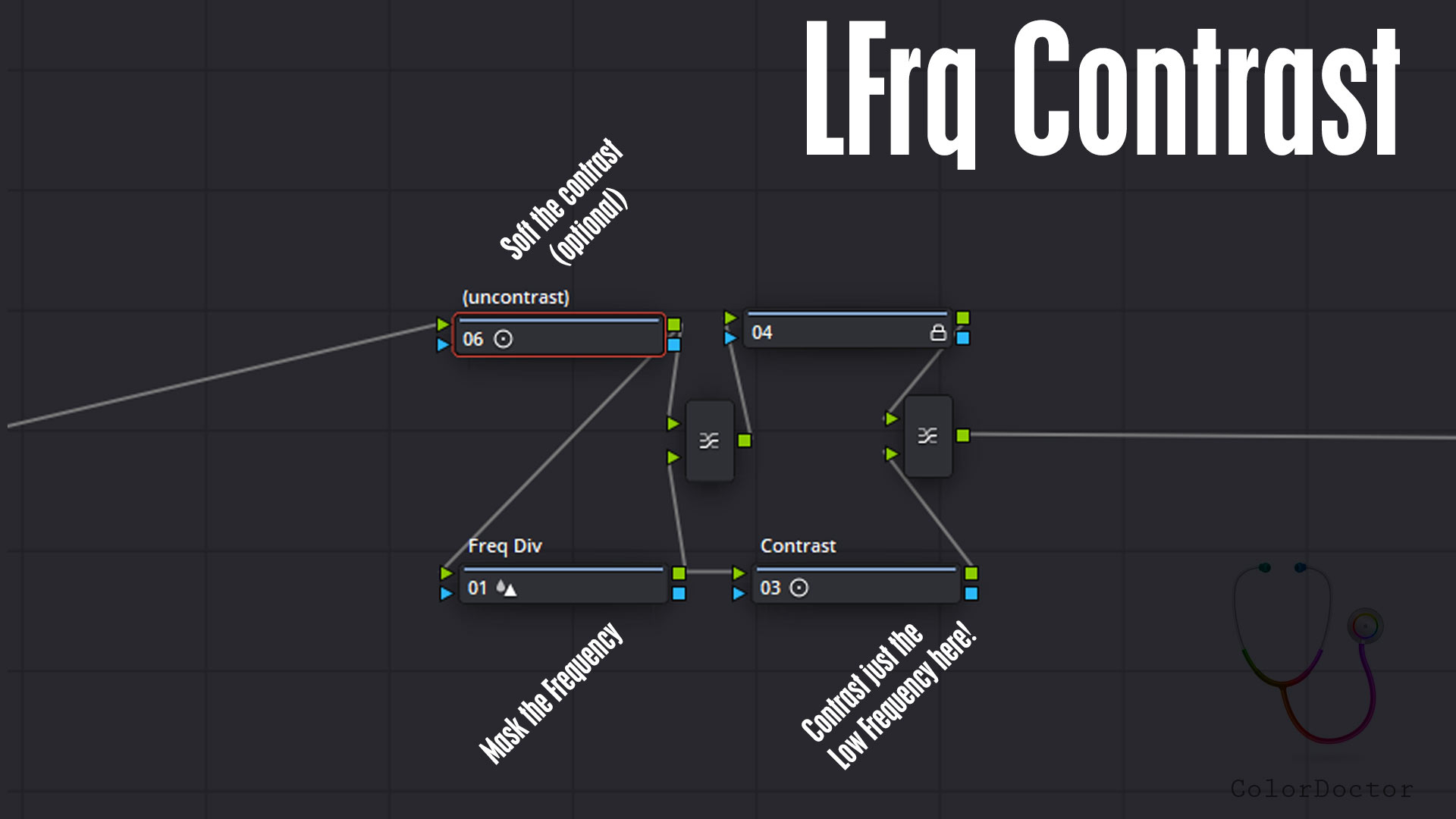

Este nodal es útil para poder contrastar sólo las bajas frecuencias espaciales.

De esta manera se facilita realizar un contraste sin incremento de contraste en detalles o texturas, localizadas en una frecuencia espacial más alta.

(uncontrast)

Este nodo opcionalmente puede ser utilizado para reducir el contraste levemente antes de realizar el contraste en bajas frecuencias. Por defecto está sin editar.

Freq Div

Este nodo posee el parámetro Blur>Radius editado, con el cual se divide la frecuencia baja a la cual se quiere procesar el contraste por separado. A mayor valor, mayor tamaño de la frecuencia a enmascarar.

Contrast

Es en este nodo donde se debe aumentar Contrast, el cual afectará sólo a la frecuencia baja. Nótese que de este modo el contraste aumentará sin crispar el detalle ni las texturas que no estén incluidas en la máscara definida en el nodo anterior. Adicionalmente se puede experimentar con Pivot y también con MD (midtone detail) para así editar detalle de las texturas sin modificar contraste general ni detalle de frecuencia alta.

Link al .drx aquí

Desde que realicé el curso de ACES, su implementación ha permitido una gran profundización en los conceptos sobre la administración del color y una ruta indispensable para la construcción de nuevos métodos de trabajo. Inicié con diez publicidades para la cadena hotelera española Barceló, donde se combinaron cámaras Red, Sony Alfa y dron DJI. Los resultados fueron excelentes al volcar todo ese registro a un solo espacio: ACES. Al ser un trabajo colorizado a distancia, la virtud de trabajar scene referred permitió tener un punto de partida muy cercano al trabajo realizado por el DP, generando un alto nivel de acierto y aprobación por parte de la agencia, el director y el DP. Para entender mejor este nuevo método de trabajo instruido por Edi Walger, cree dos proyectos en paralelo, uno en ACES cct y otro Display referred, lo que me permitió ir entendiendo las diferencias en los puntos de partida de cada uno y la manera de corregir en cada caso. Después realicé la correción de un videoclip de la artista sudafricana Alice Phoebelou, una historia fantástica de una chica que viaja por la galaxia. Muy colorido y con momentos complicados por ciertos niveles de sobre exposición sobre su rostro, fue una pieza muy interesante para el manejo de la saturación vibrante llena de matices y gran rango dinámico. Sin embargo, todas estas piezas tenían como ODT rec 709, ya que su espacio de divulgación era internet. Estos fueron los pasos de preparación para abordar dos proyectos de mayor envergadura: dos largometrajes que debía corregir fuera de mi sala en los espacios de una casa de post producción en República Dominicana. Para el primero de estos proyectos me acompañé de la asesoría formal de Edi, lo cual fue una decisión mas que acertada. Lo primero que se puso en manifiesto rápidamente fue que mi vocabulario técnico, mi nivel de seguridad y calidad de presentación de mi propuesta de trabajo había subido notablemente de nivel (concursé con otros coloristas internacionales y les cuento que ninguno mencionó ACES en su flujo), logrando que me otorgaran el contrato. Junto a Edi construimos un pipeline que incluyó el flujo de trabajo para Vfx en ACES, un nuevo reto para la casa de efectos que vio con buenos ojos comenzar a implementarlo en Nuke, algo que no habían hecho nunca.

El largometraje "Papi" de la directora puertoriqueña Noelia Quintero basado en la obra de la músico y novelista Rita Indiana, fue fotografiado por PJ López ( quien tiene uno de los rentals mas grandes de Latinoamerica), y estuvo bajo la producción de los estudios Pinewood. Usaron Red 8k como única cámara. Dados los resultados finales que se lograron en esta película, me entregaron otra producción:

" Sin aliento" un policial del director y actor italiano Ettore D'Alesandro. Filmado en Arri con lentes anamórficos, representó un reto mas complicado en lo técnico ya que su DP no presentó la misma consistencia técnica y narrativa que en la otra producción, además de que el director estaba decidido a conseguir un look bastante distante al registro original. En ambos casos pude implementar ODT P3 y contar con monitores FSI y proyector Barco en sala, un despliegue de color y rango dinámico nuevos para mi, lo cual disfruté notablemente. Luego comentaré en otra publicación sobre las dificultades encontradas, como el dominio de la piel o las alteraciones producidas por ciertas luces de neon Para finalizar les comento sobre el último trabajo en ACES, un cortometraje en blanco y negro del realizador venezolano radicado en NY Diego Murillo. Una vez mas trabajar en cct con material Arri brindó la profundidad y riqueza tonal que buscaban en esta historia. Gracias Edi y a todos los que conforman este grupo por ser un gran incentivo profesional y de mejoramiento diario. Tan pronto tenga permiso de mostrar imágenes de estas producciones las estaré compartiendo. Apenas han pasado unos meses de haber realizado el Curso de ACES, falta mucho camino por recorrer.

Rafael Lacau - Colorista

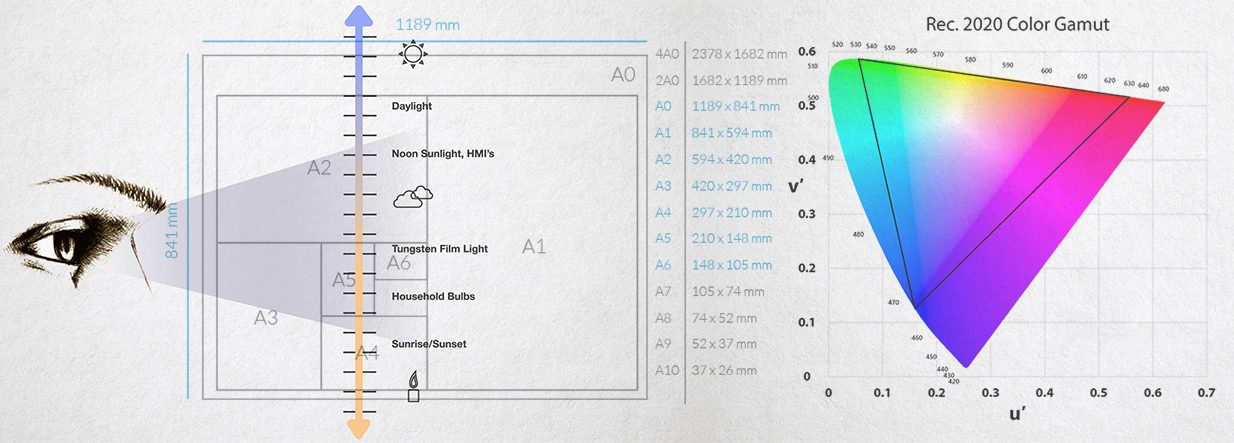

El pixel como tal es adimensional. No posee una medida absoluta, sino relativa. Y esto corre tanto para la definición como para el color. Y aunque la primera característica es fácil de interpretar, la segunda no lo es tanto.

A veces conviene traer razonamientos correctos que explican un fenómeno ya comprensible para así comprender mejor otros fenómenos más abstractos.

Como el archivo digital de imagen está construido por píxeles, estos se transformarán en algún momento en puntos visibles. Pero conocer la cantidad de píxeles de un archivo no nos dice nada en cuanto al tamaño real al cual podremos representar la imagen. Esto es porque el pixel es una medida relativa, en cambio el metro es medida absoluta. Una hoja por ejemplo no puede medirse en píxeles, pero sí en relación al metro patrón, el cual es un objeto real. El pixel es virtual, no posee dimensiones de longitud.

Definiendo entonces el PPI (pixel per inch) se establece la relación entre longitud real y puntos virtuales, de tal manera de poder representar al pixel con un tamaño en particular. El PPI expresa la cantidad de píxeles que entran en una pulgada, por lo cual define la longitud del archivo de acuerdo a la cantidad de píxeles del archivo. Falta entonces definir de qué color serán estos puntos que representarán al pixel, lo cual debería estar expresado en el pixel bajo un modelo matemático.

Pero el pixel tampoco expresa por sí mismo a un color. Sólo es color gracias a un dispositivo físico que lo transforma en real, como la impresora, el proyector o el monitor. Y por ello el dispositivo condiciona el color expresable por el pixel.

Los números que expresan el valor del pixel pueden redactarse bajo diferentes lenguas matemáticas, las cuales definen el modelo de color. Por ejemplo YUV, RGB, Lab o XYZ son Modelos, los cuales pueden expresar exactamente un mismo color con diferentes triplets de números. Es como mencionar el color Rojo en diferentes lenguas: Rouge, Red, Vermelho.

Pero Rojo en realidad todavía no significa aún un color muy determinado. Para precisar qué es “rojo”, será necesario un dispositivo que lo represente. Por ejemplo un proyector, una pantalla, una hoja con el color impreso. De acuerdo con la tecnología de representación color se podrán lograr diferentes rojos, pues en general los dispositivos crean sus paletas de color a través de la combinación de apenas tres primarios. Por lo que los colores más puros serán siempre estos tres colores sin mezcla alguna. Entonces, bajo un modelo RGB, el 100% de un primario con 0% de los otros dos generarían un límite extremo en términos de pureza cromática. Pero aún el pixel es virtual, un triplet numérico que no significa ningún color determinado, sino simplemente un “máximo” de algo que desconocemos aun.

Estos tres valores extremos de los primarios RGB puros serán mensurables cuando el dispositivo de reproducción transforme estos valores virtuales en reales. Allí serán definidos en términos absolutos, definiendo así el Gamut nativo del dispositivo.

Para compatibilizar los colores reproducibles entre diferentes tecnologías de dispositivos color se han acordado estándares, los cuales se respetan para definir Gamuts acordes a las recomendaciones de televisión HD 709, UHD 2020 o para proyecciones de cine el DCI P3. Todos los fabricantes de dispositivos entonces deberían idealmente reproducir los colores del estandar y limitar la reproducción de colores fuera de estandar que el dispositivo puede generar, y su correcta reproducción en todos los tonos intermedios logrados con la mezcla de estos tres primarios.

A este proceso se lo denomina calibración.

Sin embargo estos estándares de TV no definían un rango dinámico específico, sino sólo el aspecto de pureza cromática de los colores primarios, y nada respecto a los niveles de brillo para el negro y el blanco, o en otras palabras, no estandarizaban el rango dinámico.

Un archivo de imagen en sus dimensiones espaciales puede ser impreso en hojas A4 o en más grandes como las A3, A2 etc, pero esto no mejoraría la nitidez de la imagen. Simplemente los píxeles se imprimen más grandes, ocupando más puntos de la hoja, lo cual no genera ningún beneficio en términos de definición. Deberíamos tener archivos con más cantidad de píxeles para imprimirlos en mayor tamaño para no comprometer la definición.

Si el ancho de la página fuera la pureza cromática, el alto de la página sería entonces el rango dinámico. Una imagen wide gamut y high dynamic range entonces podría “imprimirse” en una gran hoja ancha (wide) y alta (high).

Respecto al gamut y rango dinámico, para que este pixel no sea visible como unidad, necesitaríamos mayor cantidad de bits por pixel, en vez de cantidad de píxeles por archivo. Si el cambio de tono de un pixel se hace muy “distinguible” al cambiar un sólo valor RGB, puede querer decir que no tenemos suficiente profundidad de pixel, medida en bits.

Por lo que imágenes de gamut ancho y alto rango dinámico necesitan archivos con muchos bits por pixel. Tal como necesitábamos archivos con muchos píxeles para imprimir hojas grandes sin hacer visibles a estos píxeles impresos, ahora serán necesarios más bits para no distinguir discontinuidad en un gradiente.

La TV HDR se define bajo la Rec.2100, la cual posee el gran gamut heredado del 2020, con UHD (casi 4K), y exige una profundidad mayor entre 10 y 12 bits según la variante HLG, HDR10 o DoVi.

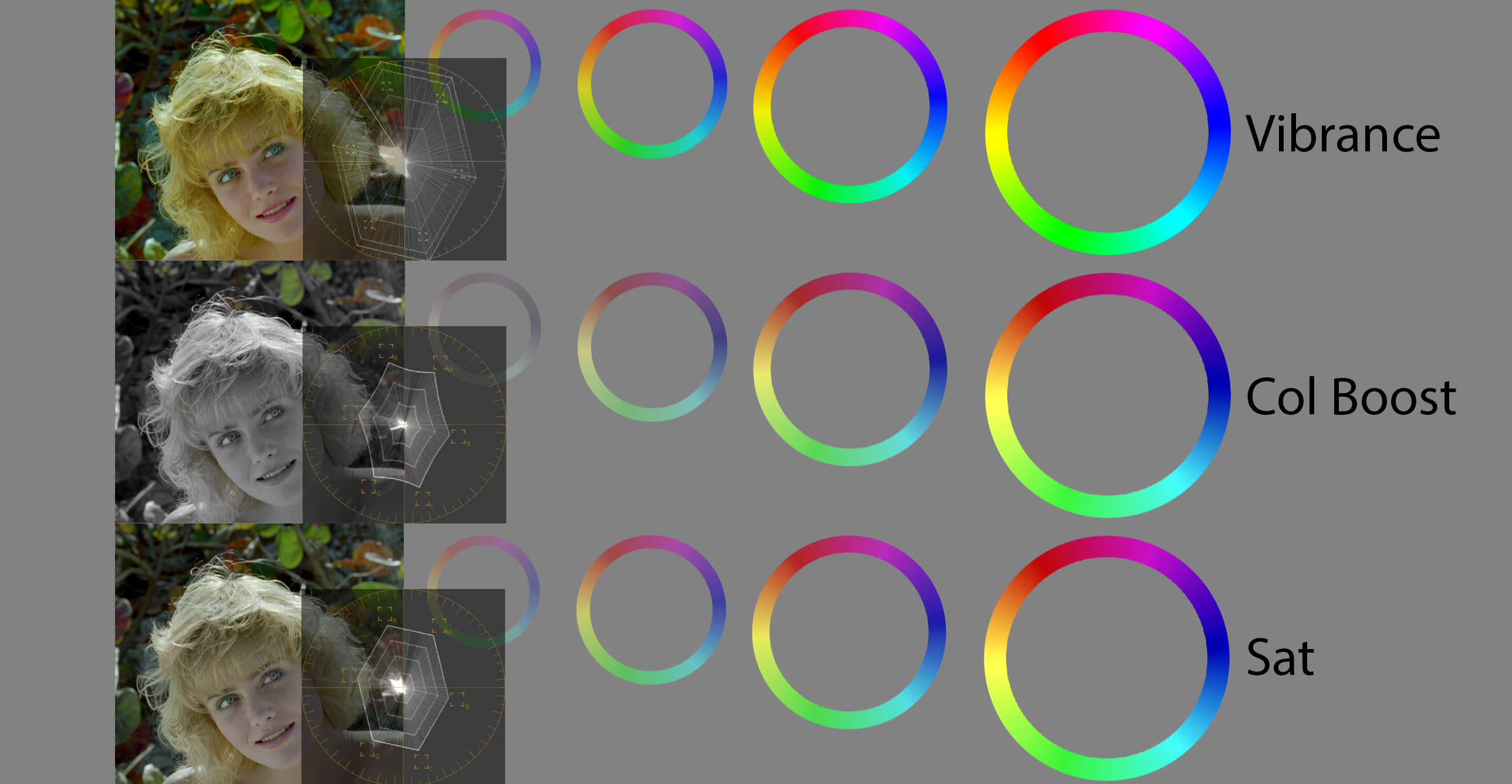

En una imagen con píxeles escritos en valores RGB, la saturación como tal no existe. Para poder modificarla habrá entonces que transformar el color a valores HSL, por ejemplo.

Una vez en este modelo de color, el canal “S” es modificable con funciones matemáticas sencillas. Por ejemplo, para escalar la saturación simplemente se multiplican los valores del canal S.

Multiplicar en el modelo RGB es lo que aplica el parámetro Gain. Este nombre tan raro fue heredado de los antiguos controles analógicos de señales, donde se aplicaba una ganancia a la señal con el objetivo de escalarla. Así que para controlar la saturación en general se utiliza la función multiply. Pero esta no es la única función aplicable a S.

Así como en RGB existe también Lift (invertir-multiplicar-invertir), existe también la opción de realizar esta secuencia de funciones sobre el canal S.

A este parámetro se lo suele denominar Vibrance.

DaVinci Resolve denomina a este parámetro como Color Boost. ¡Pero no es igual a Vibrance!